昨年、2022年11月の終わりに久しぶりの自社SEOセミナーを開催しました。今回はDemandSphere社との共催で主に中~大規模サイト向けに、Googleの傾向/ECサイト/グローバルの3つをテーマにディスカッション形式で進めました。予め脱初心者とし、少し濃い内容の話をさせていただいたのですが、私自身とても刺激的で面白かったので、セッションの内容と所感をまとめてみたいと思います。

1. データから読み解くGoogleの傾向<DemandSphere社 室屋氏>

まずは室屋さんのセッションです。

これは面白かった!! DemandSphere社のDemandMetrics(順位計測ツール)のデータをもとにいくつかのトピックの解説をしてくれました。

まずはSERPの変化から。

室屋さんは、以前は「リッチスニペット」の時代だったと振り返ります。タグホイヤーの検索結果がここ数年で本当に変化している…。右端は動画キャプチャになっていて、2022年はスクロールするほど視覚的にリッチなSERPになっていました。SERP上部にはECサイトのフィルタのようなものも表示されています。昨今はSERPそのものが大きく変化し、「リッチSERP」の時代だと室屋さんは表現しました。

ここはまさに今年注目のポイント、順位だけに注目していても不十分で、そのクエリでのSERPがどうなっているのか、何が出ているのか、総合的に見ていく必要があると思います。

そしてもう1つ、ECサイトの方であればお気づきのこちら。

アイテム系のクエリで表示される「人気商品枠」。

これ、増えてるなぁと思っていましたが、データで見ると2021年末から急増しています!

Googleはショッピングクエリに関してはどんどんビジュアル押しで責めてきてますね、やはりCTR高いのでしょう。室屋さんによると、SERPの変化によってCTRが10倍以上変化したサイトもあるようです。

人気商品枠はGoogle Merchant Centerのデータに基づいていますが、2022年9月からは構造化データを設定することで Google Merchant Center を経由せずとも無料で掲載されるようになりました。

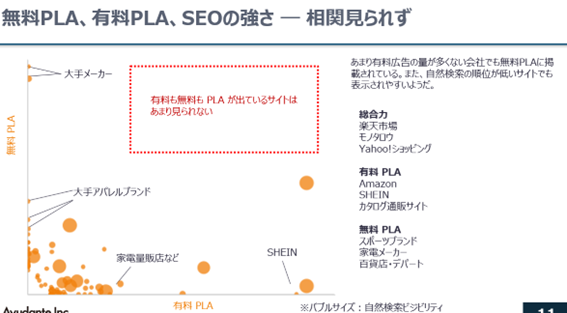

ここで気になるのが「従来の有料広告と無料枠の関係性」。この相関関係をDemandMetricsのデータで調べたのがこちら。

※PLAはProduct Listing Adsの略で、商品広告を指します。

室屋さんによると、無料と有料に相関関係は見られず、広告たくさん買っているから無料枠でも優先、SEOで上位じゃないから出にくいというわけでもないようです。

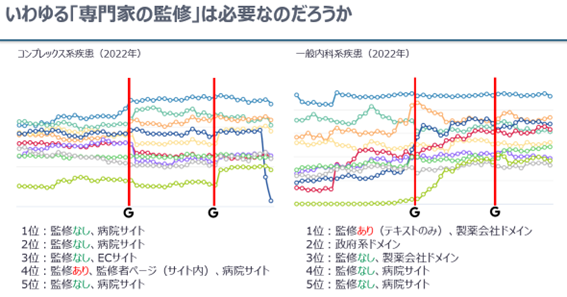

次はガラっと変わってE-A-T関連のお話。

最近どの記事でも専門家による監修者や著者情報を入れているのを目にしますが、それって本当に必要?という疑問を投げかける内容でした。

データだけ見ると、専門家の監修がなくても上位に来ているサイト、結構ありますね…。一方でコガンさんは、海外では監修が非常に重要であることを説明してくれました。

ここで大事なことは、「専門家監修」が必要なのではなく、「誰が書いているか」が重要な点です。

専門家ならだれでもいいわけではなく、何が専門領域でどんなバックグラウンドがあり、どのような活動をしていてどのような知識があるか。年末には検索品質評価ガイドラインの更新で、E-A-TにE(経験)を加えたE-E-A-Tが発表されました。ますます「誰が書くのか」が重要になりそうです。

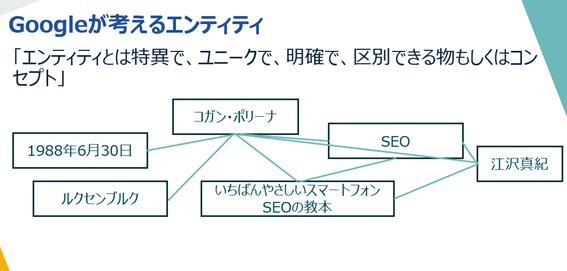

話はさらに盛り上がって、“エンティティ”についても意見を交わしました。日本ではあまり馴染みがないかもしれませんがE-E-A-Tを考える上で大切な単語ですね。以前コガンさんが実施したウエビナーより、エンティティのイメージを紹介します。

エンティティとは、キーワードの背景や関係性を踏まえた概念です。例えば有名な人の名前で検索するとナレッジパネルが出ますよね。Googleはそのクエリが人名である、そしてその人の所属や経歴、出版物や関連する人物を理解していることがわかります。

上記図でもコガンさんはSEOやSEOの書籍、私と関連性があることがわかります。そんなコガンさんが書いたコラム記事はやはりSEOというテーマで高く評価されるのではないでしょうか。

「Googleの傾向」室屋さんの考える定石と変化

定石:変化を捉えるモニタリング

変化:SERPsのリッチ化、順位以外の要素の分析

2. ECサイトでよくある課題と今後に向けて <アユダンテ 江沢>

私のパートです。

私は大規模ECサイト(DB型サイト)の定石の課題として、一覧ページの精査の話と内部リンクの話をしました。そして2023年の話として、Deep pageの重要性が増すこと、Bingのシェア拡大?について取り上げてみました。

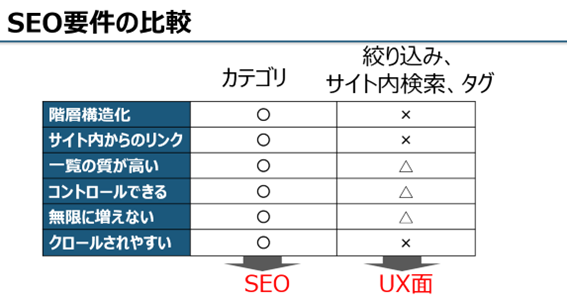

一覧ページの話は以下。

最近大規模サイトでは、様々な一覧ページができて、クロールバジェットも浪費し、検索結果でもカニバリ、収集がつかなくなっているケースをよく見ます。

私たちは大規模サイトのSEOをやるときにはまずサイト内のURLを洗い出し、要/不要に分けてそれをもとにクロールコントロールや内部リンク設計をします。

クロールコントロールをしますと、最初は一時的にオーガニック流入が落ちることもありますが、結果盛り返してかなり増加するケースが多いです。

あと、よく絞り込みやサイト内検索はパラメータURLが多いですが、URLのパラメータは本当に推奨しません。。。昨年のGoogleパラメータツール廃止も痛い事件でしたが、パラメータはやはり誤認識されることが多いです。重要なURLはしっかり疑似静的化がいいと思います。

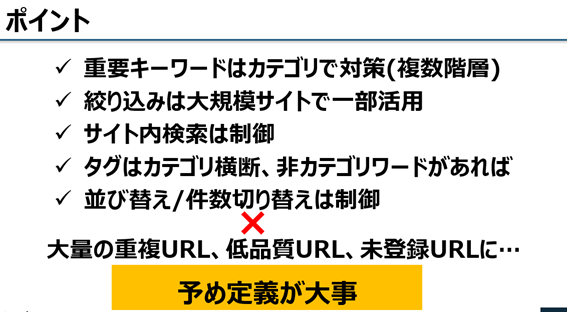

2023年の話として、Bingの話題。

Microsoft広告については弊社の岩瀬の記事がとても参考になります。

つまり、いくつかの要因によって、広告でも、SEOの、特にBtoB領域においてもMicrosoftが気になる存在なのです。実際、企業の方は会社のパソコンではデフォルトブラウザ(Egde)しか使えず、そのままBing検索しているケースが多いようです。

そこでBtoBのサイトご担当者の方はまずGoogleアナリティクスでBingの比率をチェックし、多いようであればぜひBingのウェブマスターツールだけでも入れてみてください。Bingでのインデックス状況、流入クエリなどがわかります。

上記は弊社のつぶやきデスクの流入クエリデータですが、びっくりするくらい、GoogleとBingでは流入クエリが違います…。

そして以下はつぶやきデスクの順位ですが、

例:ツイッターとは

Google:2位 / Bing:15位

悲しいくらい違います。。。

BingのSEOの傾向、Googleとはかなり違うように感じています。

「ECサイト」江沢の考える定石と変化

定石:一覧ページの精査、内部リンクが依然重要

変化:Deep pageとロングテールが重要に(商品データの精度、構造化データ、商品命名など)、BtoBはBingの動向を要チェック

3.グローバル&ローカルSEO Tips <アユダンテ コガン>

最後はコガンさんのセッション。

最近アユダンテでも問い合わせの増えてきているグローバルサイト案件。

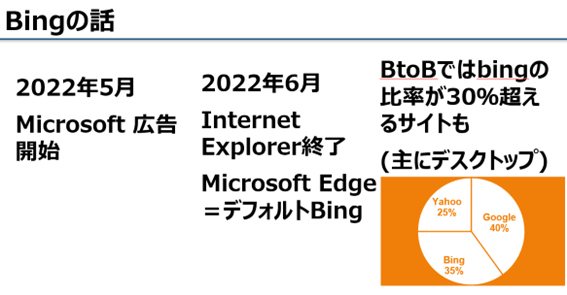

グローバルの多言語は特有のSEO要件がありますが、「ベストプラクティスの基礎は変わらず!」ということでいくつか大事な点のおさらい。

大事な点は…

・必ず国・言語バージョン別に固有のURLを持つ(言語やIPで振り分けない)

・URL形式は別ドメインでも、別サブドメインでも、別ディレクトリーでもOK(メリットデメリットの理解)

・IPを元にした強制リダイレクトはやめましょう

・hreflangをなるべくHTML内で設定する

・リージョン別の特徴を理解する

今後、日本企業が海外展開というシナリオも増えてくると思います。英語のみならあまり問題は起こりませんが、複数国で複数言語展開する場合は今一度ぜひこちらをご確認ください。

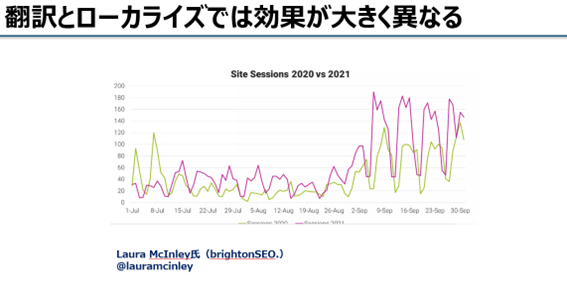

そしてグローバルはローカライズも重要。

多言語サイトの場合、自動翻訳しているケースも見かけますが、やはりその国独自の文化や背景、検索ニーズを理解して、特に現地の方がローカライズすることがベストという内容。

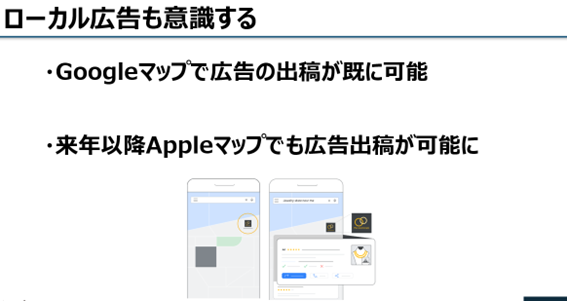

2023年の変化のところでは、海外のトレンドをいくつか紹介。

若者の検索は本当にSNSにシフトしている(していくのか)、どんどん拡大するローカル検索のマップ周りはどうなるのか、今年も要チェックですね!

「グローバル&ローカル」コガンさんの考える定石と変化

定石:グローバルSEOのベストプラクティスの基礎はかわらない、翻訳ではなくローカライズを

変化:Google以外のチャネル(Amazon、SNS)、ローカル広告、Visual search

以上の3つのセッションを3人でディスカッションしながら、そしてリアルタイムQAでいただいた質問に答えながら進めました。

今回リアルタイムQAにはアユダンテの宮下が対応しましたが、20個以上の(濃い)質問をいただきました。いくつか紹介したいと思います。

Q:P19についてURLと内部リンクがコントロールできていれば、絞り込み検索ページはむしろ強い印象ですがいかがでしょうか?

A:絞り込みに出来ないこととしてやはり階層化があるかと思います。

絞り込み条件が複数あったとき、果たしてどのような階層にするか、なかなか設計で苦労する部分です。扱う製品や量によりますが、やはりカテゴリの方がSEOには有効と思います。

(江沢)絞り込みの検索ページでもある程度対策はできると思いますが、やはり階層化できないこと(スカート>プリーツスカート)、例えば商品からのバックリンクも飛ばしにくかったりします。同等の条件で比較するとやはりカテゴリのほうがSEO的には強い印象です。

Q:ページネーションしたものをすべてインデックス送信していましたがSCでかなりの量の重複で落ちている状態なのですがそれでも1つずつインデックスさせたほうが良いのでしょうか?

A: 状況によりますが、2ページ目以降に表示される要素が1ページ目や他のページと異なるようでしたらやはりインデックスさせたほうが良いと考えております。

何故重複としてインデックスから除外されてしまっているのか、例えばtitleタグや見出しタグの内容は現在のページ数を明示できているか?1ページ目と同じ製品が出てしまっていないか?

こういった重複除外された原因を探っていただけると良いのではと思います。

Q:robots.txtのURL制御はどれくらいの規模(保有ページ数)のサイトが行った方が良いでしょうか。ECサイトだと基本制御したほうが良いでしょうか。

A:前提として、robots.txtは全てのサイトで所有いただいたほうがよいです。完全にクロール・インデックスをブロックしても良いページについてはrobots.txtに記載すると余計なクロール・インデックスを防げますので記載が必要です。

ページ数については明確な値はなく、インデックスさせたいページのインデックスが遅れていたり、あるいは更新した情報がなかなか認識されない場合には、より優先度の高いページがクロールされるようにするため制御が有効となります。

(江沢)最近さほど大規模ではないサイトでもインデックス率が芳しくないケースをよく見かけます。案外重複ページや大量の検索結果ページがクロールされているケースもあり、正確な理解をしているのであればrobots.txtを活用していったほうがいいと思います。

以上、2か月経過しちゃいましたが(汗、ウェビナーのまとめでした。

個人的には室屋さんのデータ分析のお話をもっと聞きたい!! 私たちもDemandMetricsツールは日々活用していますが、どんどん機能追加・改善されていて驚きます。

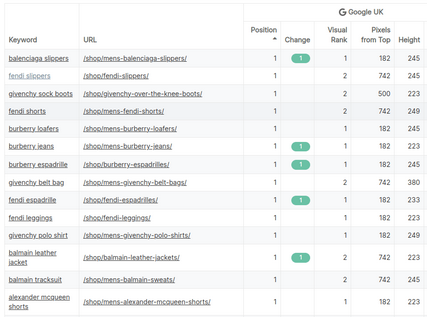

特に今回のトピックの1つ、SERPsのリッチ化。

これは今後のトレンドでサーチコンソールだけでは分析しきれない状況だと感じています。DemandMetricsでも新しくビジュアルランクという機能がリリースされています。

例えばあるキーワードで自然検索の順位は1位でも上に広告やリッチリザルトが出ているとビジュアルランクが3位とか5位になります(なんと便利!)

これが発展していくと「自分のサイトは何位?」から「自分のサイトはSERP上でどこに位置している?」が正確に分析できるようになると思います。

他にも様々な機能がアップデートされています。これで1000キーワード/5万円~ですので、順位とSERPの分析計測ツールとしてはこれ一択かなと思います。

今回のウェビナーはアンケートも「とても役立った&役立った」96%とご好評をいただいたのですが、何より「面白かった~」という感想を多々いただきましたので、ぜひ今年もディスカッション形式のウェビナーを計画していきたいと思います!

![いちばんやさしい新しいSEOの教本 第2版 検索に強いサイトの作り方[MFI対応]](https://ayudante.jp/wp-content/uploads/2018/06/seovol2_book-151x214.jpg)

![コンテンツSEOで新たな顧客層の獲得に成功! ─カタログ通販の「セシール」 [ ネットショップのためのSEO施策ゼミナール 第12回 ]](https://ayudante.jp/wp-content/uploads/2014/10/201408ezawa_nettan.png)